Die neue europäische Verordnung zu künstlicher Intelligenz, kurz EU KI Verordnung, wurde am 13. März 2024 vom europäischen Parlament angenommen und am 21. Mai 2024 formell vom Rat der Europäischen Union gebilligt. Der erste Vorschlag der Kommission lag bereits im April 2021 vor. Auf den nun finalen Text hatten sich Parlament und Rat zuletzt im Dezember 2023 geeinigt. Insgesamt zielen die neuen Regeln darauf ab, Grundrechte, Demokratie und Rechtsstaatlichkeit sowie ökologische Nachhaltigkeit vor Hochrisiko-KI-Systemen zu schützen.

Intention und Zielrichtung

Die EU KI-Verordnung (KI-VO) ist momentan das weltweit erste Gesetz zur umfassenden Regulierung von „Künstlicher Intelligenz“ (KI).

Fast so aktuell ist eine Gesetzesinitiative in Brasilien wo aufgrund des breiten Einsatzes biometrischer Gesichtserkennung und daraus resultierender Probleme und Ungerechtigkeiten, unter anderem aufgrund fälschlicher Verhaftungen, die Dringlichkeit im Alltag offensichtlich ist. Diese Initiative liegt dem brasilianischen Kongress seit Dezember 2023 als inzwischen vierte Gesetzesentwurf zur Schaffung eines Rechtsrahmens für künstliche Intelligenz vor. Dieses Gesetz muss allerdings noch verabschiedet werden.

Bei der KI-VO der EU geht es aber nicht nur um derzeit hoch gehandelte und durch große Teile der Bevölkerung genutzte Systeme, wie beispielsweise die Anwendung ChatGPT. Die EU-Verordnung setzt viel weiter an und zielt auch und gerade auf die Regulierung und Überwachung von Software ab, die beispielsweise auf Überwachungskameras an öffentlichen Orten Gesichtserkennung einsetzt oder verdächtige Bewegungsmuster erfassen soll, auf im Personalwesen eingesetzte Software zur Vorsortierung und Erfassung von Lebensläufen im Bewerbungsverfahren bis hin zum, laut Gesetz verbotenen, Einsatz von KI für so genanntes „Social Scoring“. So nennt man beispielsweise in China zum Einsatz kommende Punktesysteme, die Bürger für erwünschtes Verhalten belohnen und für unerwünschtes Verhalten bestrafen.

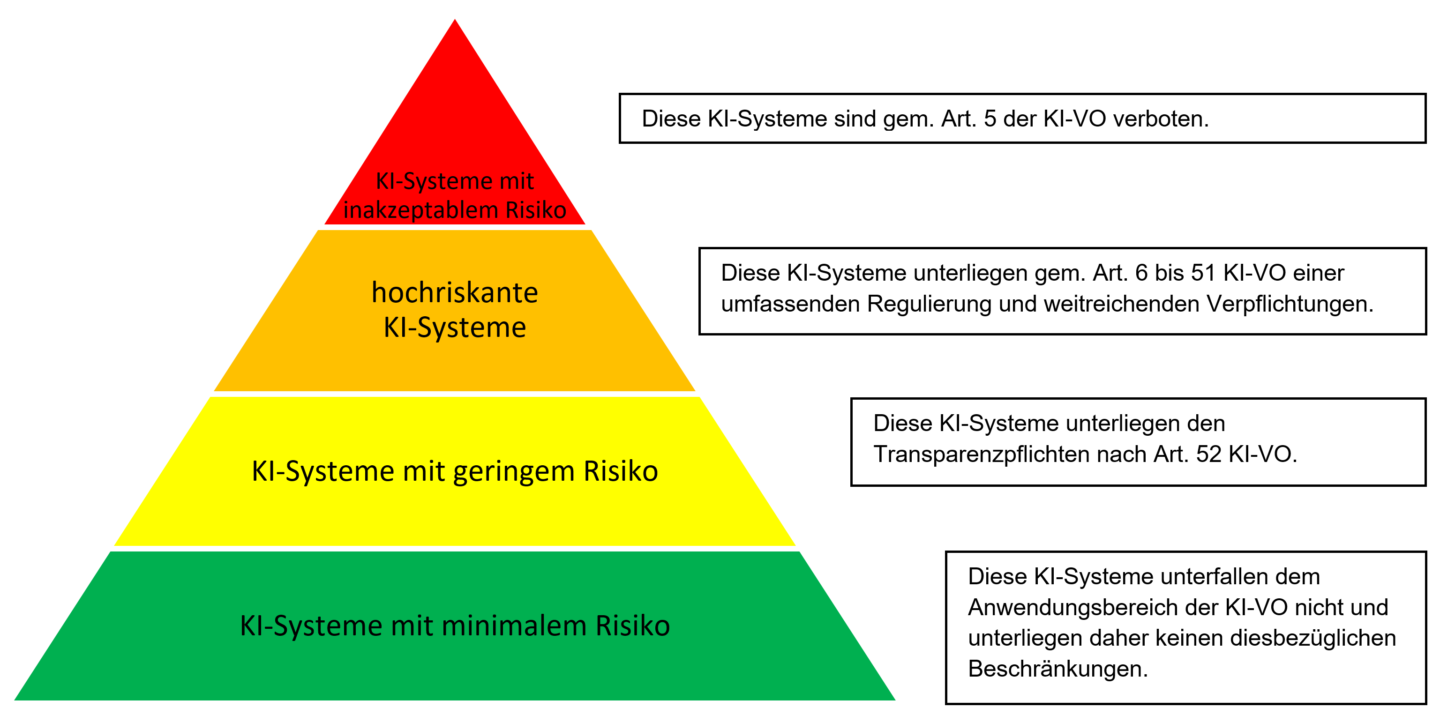

Ziel der EU ist es, vertrauenswürdige KI zu fördern, indem der Schutz der Grundrechte sichergestellt und die Einhaltung und Sicherung ethischer Grundsätze gefördert wird. Weiterhin wird KI in verschiedene Risikoklassen unterteilt, deren Einsatz je nach ihrer Einordnung bestimmten Auflagen unterworfen oder sogar gänzlich untersagt wird. Je höher das Risiko, desto strenger sollen die Anforderungen an das KI-System sein. Je nachdem, in welche Risikokategorie eine Dienstleistung oder ein Produkt eingestuft wird, müssen Unternehmen zukünftig eine Reihe von Transparenz- und Datenschutzvorschriften einhalten.

Der EU ist gleichzeitig daran gelegen, Innovationen anzukurbeln und eine Vorreiterposition der EU im Bereich KI einzunehmen, wobei sich noch zeigen wird, ob das Gesetz mit seiner weitgehenden Begrenzung der möglichen Innovationen durch ein Korsett von Reglementierungen eine solche nicht grundsätzlich eher verhindert als fördert. Die Balance zwischen Schutz vor Grundrechtsverletzungen oder einem „Big brother is watching you“ zu halten und andererseits eine zukunftsweisende Entwicklung möglicher KI-Systeme auf europäischem Boden zu ermöglichen, erscheint angesichts der schnellen Entwicklung im KI-Bereich einer Sisyphos-Aufgabe nicht unähnlich.

Kritische Stimmen zur KI

Die dahinterstehenden Intentionen sind zweifellos gut. Kritiker gibt es auf beiden Seiten, manchen geht das Gesetz nicht weit genug, andere bemängeln, es hielte die Innovation zurück und angesichts der schnellen Weiterentwicklung der Technik würden, die durch das Gesetz umfassten Definitionen ohnehin bald den relevanten Bereich gar nicht mehr erfassen können, da dieser der zu eng gefassten Definition längst entwachsen wäre.

Daniel Abbou, Geschäftsführer des KI-Verbands, der mehr als 400 Mitglieder in Deutschland zählt, kritisiert, die KI-VO könne „die europäische Innovation behindern“. Abbou unterstützt grundsätzlich das Vorhaben einer allgemeiner KI-Regulierung in Europa, ist aber der Ansicht, dass die neue Verordnung Startups, die mit den großen amerikanischen Tech-Firmen konkurrieren wollen, nur zusätzliche Bürokratie auferlegen wird (AI Act: Deutscher KI-Verband übt Kritik am EU-Gesetz – Business Insider).

Der Sachverständige Jürgen Geuter ist der Ansicht, der Entwurf setzte zu stark auf Zukunftsnarrativen auf. „Wir versuchen jetzt Regelungen aufzuschreiben, für eine Fiktion, die in fünf bis zehn Jahren Realität sein soll“, sagte er. Es bestehe jedoch die Frage, ob KI-Systeme überhaupt reglementiert werden müssten. Zwar könnten diese letztlich diskriminieren, „wenn sie so eingesetzt werden“. Eine solche Diskriminierung entstünde aber letztlich immer aus der Situation heraus, wenn KI-Systeme, als Teil größerer Infrastruktursysteme, implementiert würden.

Sam Altman, der CEO von OpenAI, der mit Microsoft eine milliardenschwere Partnerschaft eingegangen ist, stellte sich zunächst auf den Standpunkt, dass sein Unternehmen im worst case seinen Betrieb in der EU gänzlich einstellen könnte, sollte es nicht in der Lage sein, alle gesetzlichen Vorschriften einzuhalten. Einige Tage später sprach er sich dann aber für eine allgemeine Regulierung aus.

„Seien wir realistisch: Amerikanische Unternehmen haben ihre Modelle ohne Regulierung und mit viel Geld entwickelt. Jetzt, wo sie diese Modelle haben, die die Nummer eins in der Welt sind, sagen sie, wir brauchen eine Regulierung“, sagt Abbou vom KI-Verband. „Das EU-Gesetz über künstliche Intelligenz birgt die Gefahr, dass es ihren Marktanteil noch mehr stärkt“.

Kai Zenner, Büroleiter und Digitalpolitik-Berater des Europaabgeordneten Axel Voss, der in Brüssel an der Ausarbeitung des KI-Gesetzes beteiligt war, äußert sich dahingehend, dass der deutlich merkliche Produktsicherheitsansatz der Verordnung letztlich einfach nicht zum Thema KI passe. „Produktsicherheitsgesetze zielen auf Produkte ab, die eine feste Form haben, etwa eine Flasche oder ein Staubsauger. KI entwickelt sich jedoch weiter und kann neue Fähigkeiten antrainiert bekommen. Was passiert dann? Muss der KI-Entwickler ständig neue Konformitätsprüfungen durchführen? Compliance Kosten werden in die Höhe schießen. So werden wir wohl nicht KI-Weltmarktführer.“

Überblick über die KI-VO

Ein System der künstlichen Intelligenz (KI-System) definiert Art. 3 Abs. 1 der KI-VO wie folgt: „Ein maschinengestütztes System, das so konzipiert ist, dass es mit unterschiedlichem Grad an Autonomie operieren kann und nach seiner Einführung Anpassungsfähigkeit zeigt, und das für explizite oder implizite Ziele aus den Eingaben, die es erhält, ableitet, wie es Ergebnisse wie Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen erzeugen kann, die physische oder virtuelle Umgebungen beeinflussen können.“

Die KI-VO der EU (PDF) teilt die verschiedenen Modelle des maschinellen Lernens – je nach dem Risiko, das sie für die Gesellschaft darstellen – in vier Kategorien ein, wobei Modelle mit hohem Risiko den restriktivsten Vorschriften unterliegen.

Die Risiko-Kategorien der KI-VO

1. Inakzeptables Risiko

In die Kategorie „inakzeptables Risiko“, fallen alle KI-Systeme, die als eindeutige Bedrohung für die Sicherheit, den Lebensunterhalt und die Rechte der Menschen angesehen werden. Ausreichend ist hierfür ein potentieller Schadenseintritt, der mit „hinreichender Wahrscheinlichkeit“ abzusehen ist. Dies reicht von der sozialen Bewertung durch Regierungen (sog. Social Scoring) über biometrische Identifizierung in Echtzeit im öffentlichen Raum bis hin zu Verhaltensmanipulation fördernden Systemen, wie z.B. Spielzeug mit Sprachassistenz, das zu gefährlichem Verhalten ermutigt. Solche KI-Systeme mit inakzeptablem Risiko werden grundsätzlich verboten.

Es gibt jedoch bestimmte ausführlich beschriebene und eng abgegrenzte Ausnahmefälle für Strafverfolgungsbehörden. Fernidentifizierung in Echtzeit ist nur unter Einhaltung strenger Sicherheitsbestimmungen erlaubt – unter anderem gibt es zeitliche und räumliche Beschränkungen, und es muss vorab eine spezielle behördliche oder gerichtliche Genehmigung eingeholt werden. Entsprechende Systeme dürfen beispielsweise genutzt werden, um gezielt nach einer vermissten Person zu suchen oder einen Terroranschlag zu verhindern. Auch der Einsatz von KI-Systemen zur nachträglichen Fernidentifizierung gilt als hochriskant. Hierfür ist eine gerichtliche Genehmigung nötig, die mit einer Straftat in Verbindung stehen muss.

2. Hohes Risiko

Insbesondere KI-Systeme, die in den Bereichen kritische Infrastruktur, allgemeine und berufliche Bildung oder Beschäftigung eingesetzt werden, gelten als hochriskant, wie auch der Einsatz von KI für grundlegende private oder öffentliche Dienstleistungen, wie beispielsweise im Bank- oder Gesundheitswesen, bestimmten Bereichen der Straffverfolgung, der Justiz, dem Migrations- und Grenzmanagement oder der Beeinflussung von demokratischen Prozessen wie Wahlen.

KI-Systeme gelten auch dann als risikoreich, wenn sie ein Profil von Personen erstellen, beispielsweise, wenn sie personenbezogene Daten automatisiert verarbeiten, um verschiedene Aspekte des Lebens einer Person zu bewerten, z.B. Arbeitsleistung, wirtschaftliche Lage, Gesundheit, Vorlieben, Interessen, Zuverlässigkeit, Verhalten, Standort oder Bewegung.

Bei Einsatz vom KI-Systemen in derartigen Bereichen muss daher eine genaue Risikobewertung und -verringerung erfolgen, es müssen Nutzerprotokolle geführt werden und der Einsatz der KI hat transparent und genau zu erfolgen. Weiterhin ist eine Überwachung und Beaufsichtigung der KI-Systeme durch Menschen sicherzustellen.

Die neue KI-VO verankert zudem das Recht der Bevölkerung zukünftig Beschwerden über derart eingesetzte KI-Systeme einzureichen und Entscheidungen, die auf Grundlage solcher hochriskanten KI-Systeme getroffen wurden und ihre Rechte beeinträchtigen, erklärt zu bekommen.

Exkurs: Transparenzanforderungen

KI-Systeme mit allgemeinem Verwendungszweck und die Modelle, auf denen sie beruhen, müssen konkrete Transparenzanforderungen erfüllen, unter anderem die Einhaltung des EU-Urheberrechts und die Veröffentlichung detaillierter Zusammenfassungen der für das Training verwendeten Inhalte. Zusätzliche Anforderungen gelten für die leistungsfähigeren Modelle, die systemische Risiken bergen könnten. So müssen beispielsweise Modellbewertungen durchgeführt, systemische Risiken bewertet und gemindert und potentielle Vorfälle gemeldet werden. Darüber hinaus sind künstlich erzeugte oder bearbeitete Bilder bzw. Audio- und Videoinhalte (sogenannte Deepfakes) in Zukunft eindeutig als solche zu kennzeichnen.

KI-Systeme mit allgemeinem Verwendungszweck und die Modelle, auf denen sie beruhen, müssen konkrete Transparenzanforderungen erfüllen, unter anderem die Einhaltung des EU-Urheberrechts und die Veröffentlichung detaillierter Zusammenfassungen der für das Training verwendeten Inhalte. Zusätzliche Anforderungen gelten für die leistungsfähigeren Modelle, die systemische Risiken bergen könnten. So müssen beispielsweise Modellbewertungen durchgeführt, systemische Risiken bewertet und gemindert und potentielle Vorfälle gemeldet werden. Darüber hinaus sind künstlich erzeugte oder bearbeitete Bilder bzw. Audio- und Videoinhalte (sogenannte Deepfakes) in Zukunft eindeutig als solche zu kennzeichnen.

3. Geringes/begrenztes Risiko

Das so genannte geringe, oder begrenzte Risiko bezieht sich auf einen mittleren Grad der Transparenz bei der Nutzung von KI. Als Beispiel wird die Interaktion mit KI-Chatbots genannt und die notwendige Voraussetzung, dass sich die Nutzer bewusst sind, dass sie mit einer Maschine interagieren, sowie die Gewährleistung, dass KI-generierte Inhalte auch als solche identifizierbar sein müssen.

Entwickler von „General Purpose“ KI-Modellen müssen zukünftig detaillierte Zusammenfassungen der zum Trainieren derartiger Systeme verwendeten Daten aushändigen und zudem auf Einhaltung der geltenden EU-Urheberrechtsvorschriften achten.

Auch mit Hilfe von KI erstellte Deepfake-Inhalte, sind zukünftig im Einklang mit der KI-VO erkennbar als „künstlich manipuliert“ zu kennzeichnen.

4. Minimales Risiko

KI-Systeme mit minimalem Risiko sind unreguliert für den Gebrauch freigegeben (freie Nutzung). Hierzu zählen Anwendungen wie KI-gestützte Videospiele oder Spam-Filter. Nach Angaben der EU dürfte derzeit der überwiegende Teil der in der EU eingesetzten KI-Systeme in diese Kategorie fallen.

Regulierungsbehörde auf EU-Ebene: Das KI-Büro

Im Rahmen der KI-VO hat die Europäische Kommission eine neue Regulierungsbehörde auf EU-Ebene eingerichtet: das Europäische Amt für künstliche Intelligenz (kurz auch: „KI Büro“), das in der Generaldirektion für Kommunikationsnetze, Inhalte und Technologie (GD CNECT) der Europäischen Kommission angesiedelt sein wird.

Aufgabe des KI-Büros wird es ein, die Anforderungen der KI-VO an KI-Modellen und KI-Systemen für allgemeine Zwecke (GPAI) in den 27 EU-Mitgliedstaaten zu überwachen, zu beaufsichtigen und durchzusetzen. Dies umfasst sowohl die Analyse neu auftretender, unvorhergesehener Systemrisiken, die sich aus der Entwicklung und dem Einsatz von GPAI ergeben, als auch die Entwicklung von Fähigkeitsbewertungen, die Durchführung von Modellbewertungen und die Untersuchung von Vorfällen mit potenziellen Verstößen und Nichteinhaltung. Anbietern von GPAI-Modellen soll es erleichtert werden, sich an die Vorschriften zu halten, weshalb das Amt für künstliche Intelligenz freiwillige Verhaltenskodizes erstellt, deren Einhaltung eine Konformitätsvermutung begründen soll.

Nachgelagerte Anbieter können zudem unmittelbar beim KI-Büro eine Beschwerde über die Verletzung durch vorgelagerte Anbieter einreichen.

Maßnahmen zur Förderung von Innovationen und KMU

Ein weiteres Anliegen bei der Erstellung der KI-VO war die Förderung von Innovationen sowie die Förderung von kleinen und mittleren Unternehmen (KMU).

Zu diesem Zweck wird das Amt für künstliche Intelligenz zur Unterstützung der KMU in der EU:

• eine einheitliche Informationsplattform entwickeln und pflegen, die allen EU-Akteuren leicht zugängliche Informationen über diese Verordnung bietet sowie

• geeignete Kommunikationskampagnen organisieren, um das Bewusstsein für die Anforderungen der Verordnung zu schärfen.

Die Art. 57 bis 63 der KI-VO befassen sich mit dieser Thematik. Explizit ist hier die Rede von Sandkästen zur Erprobung und später auch von Test außerhalb der Sandkästen.

Die gemäß Artikel 57 Absatz 1 der KI-VO eingerichteten regulatorischen KI-Sandkästen sollen für ein kontrolliertes Umfeld sorgen, dass die Innovation fördert und die Entwicklung, Schulung, Erprobung und Validierung innovativer KI-Systeme für einen begrenzten Zeitraum erleichtert, bevor diese auf den Markt gebracht oder in Betrieb genommen werden.

Die Einrichtung von KI-Sandkästen soll unter anderem Innovation und Wettbewerbsfähigkeit fördern und auch den Zugang zum Unionsmarkt für KI-Systeme erleichtern und beschleunigen, insbesondere wenn sie von KMU, einschließlich Start-ups, angeboten werden.

Die Mitgliedstaaten müssen daher laut KI-VO sicherstellen, dass ihre zuständigen Behörden auf nationaler Ebene mindestens eine KI-Sandbox einrichten, die spätestens 24 Monate nach Inkrafttreten der Verordnung einsatzbereit ist. Der Sandkasten kann auch gemeinsam mit einer oder mehreren zuständigen Behörden eines anderen Mitgliedstaats eingerichtet werden. Diese Reallabore müssen für kleine und mittlere Unternehmen sowie für Start-ups zugänglich sein, damit sie innovative KI-Systeme entwickeln und trainieren können, bevor sie auf den Markt kommen. Der Zugang zu den KI-Reallaboren ist laut KI-VO für KMU, einschließlich Start-ups, kostenlos, unbeschadet außergewöhnlicher Kosten, die durch die zuständigen nationalen Behörden auf faire und verhältnismäßige Weise zurückgefordert werden können. Die Teilnahme an der KI-Real-Sandbox ist dabei auf einen Zeitraum begrenzt, der der Komplexität und dem Umfang des Projekts angemessen ist und von der zuständigen nationalen Behörde verlängert werden kann.

Zudem enthält Artikel 62 KI-VO noch weitergehende Fördermaßnahmen für Anbieter und Verleiher, insbesondere für KMU, einschließlich Start-Ups, welche bevorzugter Zugang zu den Sandkästen, spezifische Schulungsmaßnahmen, spezielle angepasste Gebührenregelungen und neuer Kommunikationskanäle für diese Adressaten regeln.

Umsetzungszeitrahmen

Die KI-VO soll innerhalb von zwei Jahren vollständig umgesetzt sein. Es ist daher nun an den Mitgliedsstaaten sämtliche Anwendungen zu überprüfen und die notwendigen Anforderungen zu erfüllen oder verbotene Systeme abzuschalten. Weiterhin sind bekannt gewordene Verstöße bei den nationalen Behörden zu melden. Diese können bei Meldung von Verstößen Überwachungsverfahren einleiten und gegebenenfalls Strafen verhängen. Die einzelnen Mitgliedstaaten sollen Sanktionen (beispielsweise Geldstrafen) beschließen, die zum Tragen kommen, wenn Unternehmen sich nicht an die Vorgaben halten.

Die Verordnung tritt 20 Tage nach ihrer Veröffentlichung im Amtsblatt der EU in Kraft und ist – bis auf einige Ausnahmen – 24 Monate nach ihrem Inkrafttreten uneingeschränkt anwendbar. Die Ausnahmen sind Verbote sogenannter verbotener Praktiken, die bereits sechs Monate nach Inkrafttreten gelten sollen (voraussichtlich Nov. 2024), Verhaltenskodizes (Geltung neun Monate nach Inkrafttreten), Regeln für künstliche Intelligenz mit allgemeinem Verwendungszweck, einschließlich Governance, (zwölf Monate nach Inkrafttreten) und Verpflichtungen für Hochrisikosysteme (erst 36 Monate nach Inkrafttreten).

Nach der nun erfolgten Billigung der Verordnung durch den Europäischen Rat werden in der Übersetzungsphase des Gesetzes, in der die EU-Gesetze in die Sprachen aller Mitgliedstaaten übersetzt werden, letzte kleinere sprachliche Änderungen vorgenommen und eine Veröffentlichung nun für Ende Juni 2024 erwartet.